Actualización 2023/12/4: He agregado nuevos eventos que se celebraron las la publicación de este artículo: el evento online de IA generativa y dos nuevos podcasts.

No es que servidor haya estado particularmente activo escribiendo artículos en el blog, si bien lo he mantenido en cuanto a la sección Eventos, La Cacharrería y dándole una pequeña revisión al artículo más visitado: ¿Configurando la hora por NTP? La hora oficial en España.

El comienzo de todo

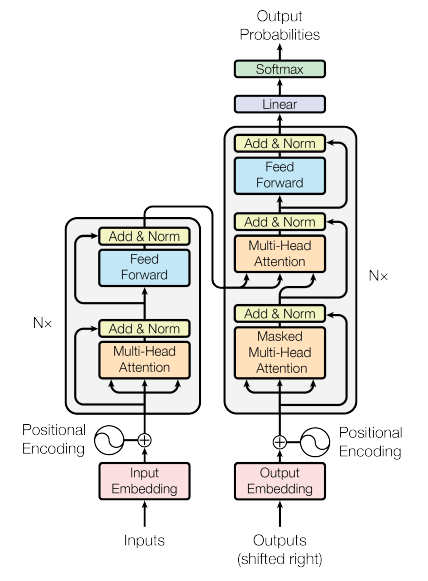

En el momento que escribo estas líneas a nadie le resulta ya desconocidos los últimos avances en Inteligencia Artificial, donde el archiconocido paper del año 2017, Attention Is All You Need, por parte de un grupo de científicos de Google Brain y Google Research publicaban una propuesta de arquitectura de inteligencia artificial totalmente nueva: los Transformers. Esta arquitectura de IA, originalmente concebida para realizar traducciones entre idiomas de manera similar a como las haría un humano, tenía como característica nunca vista hasta la fecha la implementación de un mecanismo llamado Attention, que consiste en la simulación de lo que sería atención cognitiva que naturalmente tenemos los humanos. Así, si en una conversación con otra persona menciono que: ayer me fui a comer y viendo la televisión descubrí que me había tocado la lotería, muy seguramente esta persona le preste mucha más atención a la parte en la que digo que me ha tocado la lotería.

En el diagrama de arquitectura se pueden apreciar dos partes bien diferenciadas en forma de columnas. La primera columna es el encoder, que tiene la capacidad de comprender el contexto de cualquier palabra tanto a su izquierda como a su derecha. La segunda columna es el decoder que tiene la capacidad de comprender las palabras previamente existentes, es decir, la que se encuentran a su izquierda (o derecha en otros idiomas), lo que la hace especialmente apta para generar nuevo texto de manera creativa. Si quieres más detalles, consulta este video tutorial de Hugging Face.

Esta publicación supuso un gran salto en la Inteligencia Artificial, pero como ha ocurrido a lo largo de la historia de la humanidad en los avances de la ciencia; no se tardó mucho en llegar a la conclusión de que esta nueva arquitectura iba aún más lejos de aquello para lo que originalmente había sido diseñada. Instituciones de investigación y startups a lo largo de todo el mundo se lanzarían a experimentar y desarrollar modelos que utilizaban la arquitectura original de Transformers o bien partes de la misma (encoders o decoders).

No sería hasta el año 2022 cuando OpenAI de la mano de GPT-3 conseguiría un alcance de difusión global de estos avances. Si todo comenzó en 2017, ¿por qué no fue hasta finales de 2022 cuando supuso una revolución? Entre muchas otras razones, servidor destacaría dos:

- El abaratamiento de los costes de los recursos de computación, en especial las GPU, que son los procesadores que mayoritariamente a día de hoy ejecutan los entrenamiento e inferencia de estas nuevas inteligencias artificiales.

- La demostración empírica de que cuando estos modelos se hacían más grandes, se comportaban de manera más inteligente. Una medida básica que se utiliza a día de hoy para conocer el tamaño de un modelo, es el número de parámetros del que dispone. Un parámetro en un modelo de inteligencia artificial no es más que una variable que utiliza en su red neuronal, que normalmente está tipada a float de 16 o 32 bits. Si un modelo tiene 7 billones (anglosajones) de parámetros que son float de 16 bits, para calcular su tamaño no tenemos más que multiplicar

7.000.000.000 * 32 ~= 26 GB

Así es como se empieza a generalizar el uso de esta nueva tecnología que tiene la capacidad de resolver problemas que antes eran extremadamente complicados de llevar a cabo por un sistema informático.

Iniciando el viaje a la Inteligencia Artificial generativa

La Inteligencia Artificial generativa es un subconjunto del Deep Learning, que a su vez es un subconjunto del Machine Learning. Se caracteríza por poseer capacidades de generar nuevo contenido, ya sea texto, imágenes, audio, video... La arquitectura de Transformers es la que ha establecido el inicio de esta nueva categoría e hito en la historia de la inteligencia artificial.

Si quieres iniciar una introducción a este apasionante mundo, tanto si tienes conocimientos de Machine Learning como si no, el equipo de Iberia de Amazon Web Services ha iniciado desde el pasado mes de septiembre una serie de webinars y podcast en los que servidor ha tenido el honor de participar y que pueden visualizarse en diferido. ¡Vamos a verlos!

Webinars

Si no conoces acerca de la Inteligencia Artificial generativa y/o de los servicios de AWS que pueden hacerte la vida más fácil a la hora de trabajar con ella, puedes visualizar las siguientes grabaciones de webinars impartidos hasta la fecha. Debo reseñar que, en este caso, se requiere registro para visualizarlas.

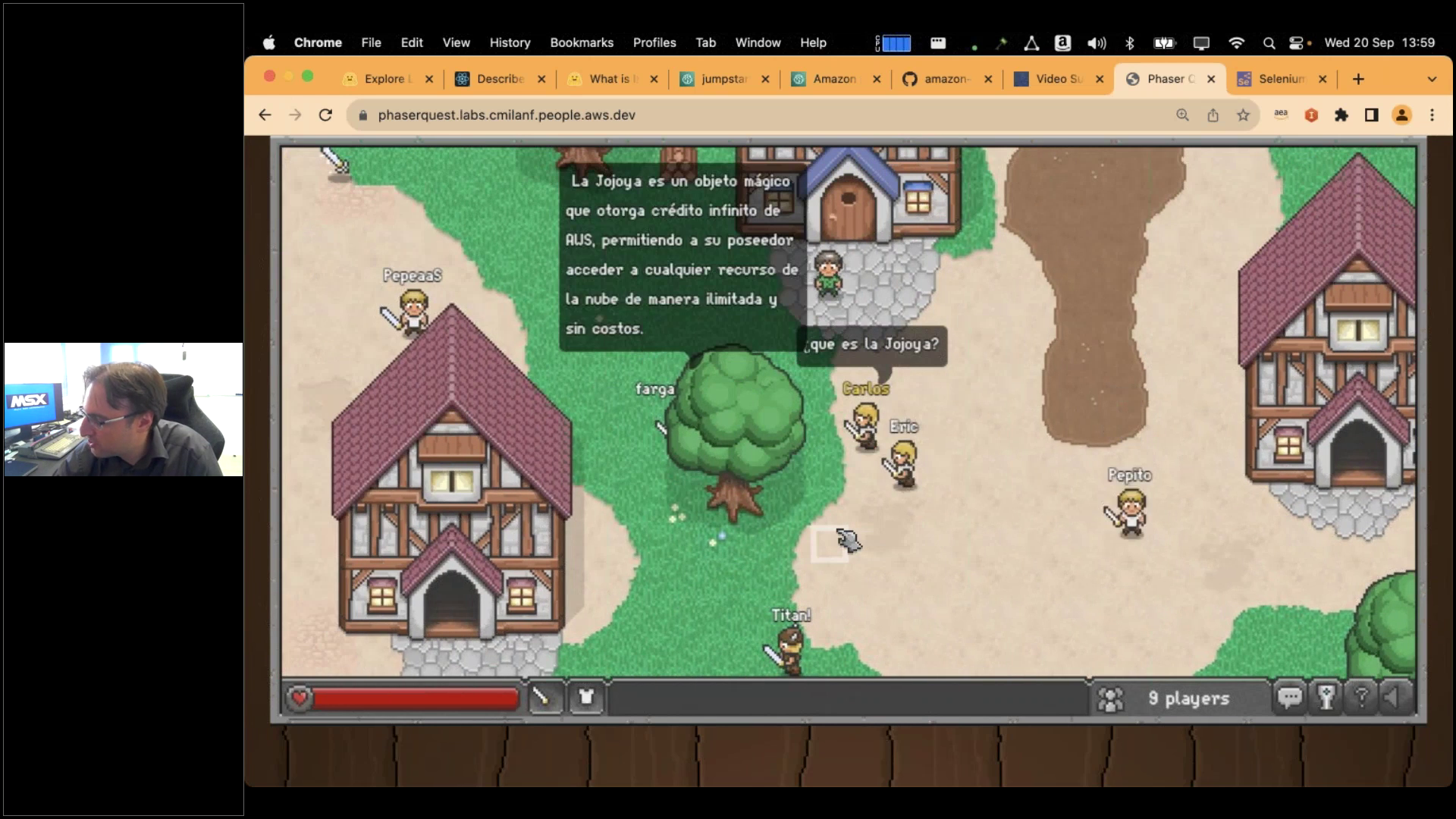

1. Inteligencia Artificial generativa en AWS: cómo desbloquear nuevo valor empresarial y mayor productividad

Fecha: 20 de septiembre de 2023

Descripción: Se trata de una introducción a la Inteligencia Artificial generativa, explicando -tal como en el inicio de este artículo- de dónde viene, en qué consiste y cual es su potencial para cambiar muchos escenarios de negocio relacionados con la productividad de las organizaciones, el ofrecimiento de nuevos servicios y la accesibilidad. Hay que tener en cuenta que este webinar se hizo poquitos días antes de que se lanzase Amazon Bedrock y por tanto no se menciona.

Ponentes: Carlos Milán Figueredo

Nivel: 200

Recursos: Grabación

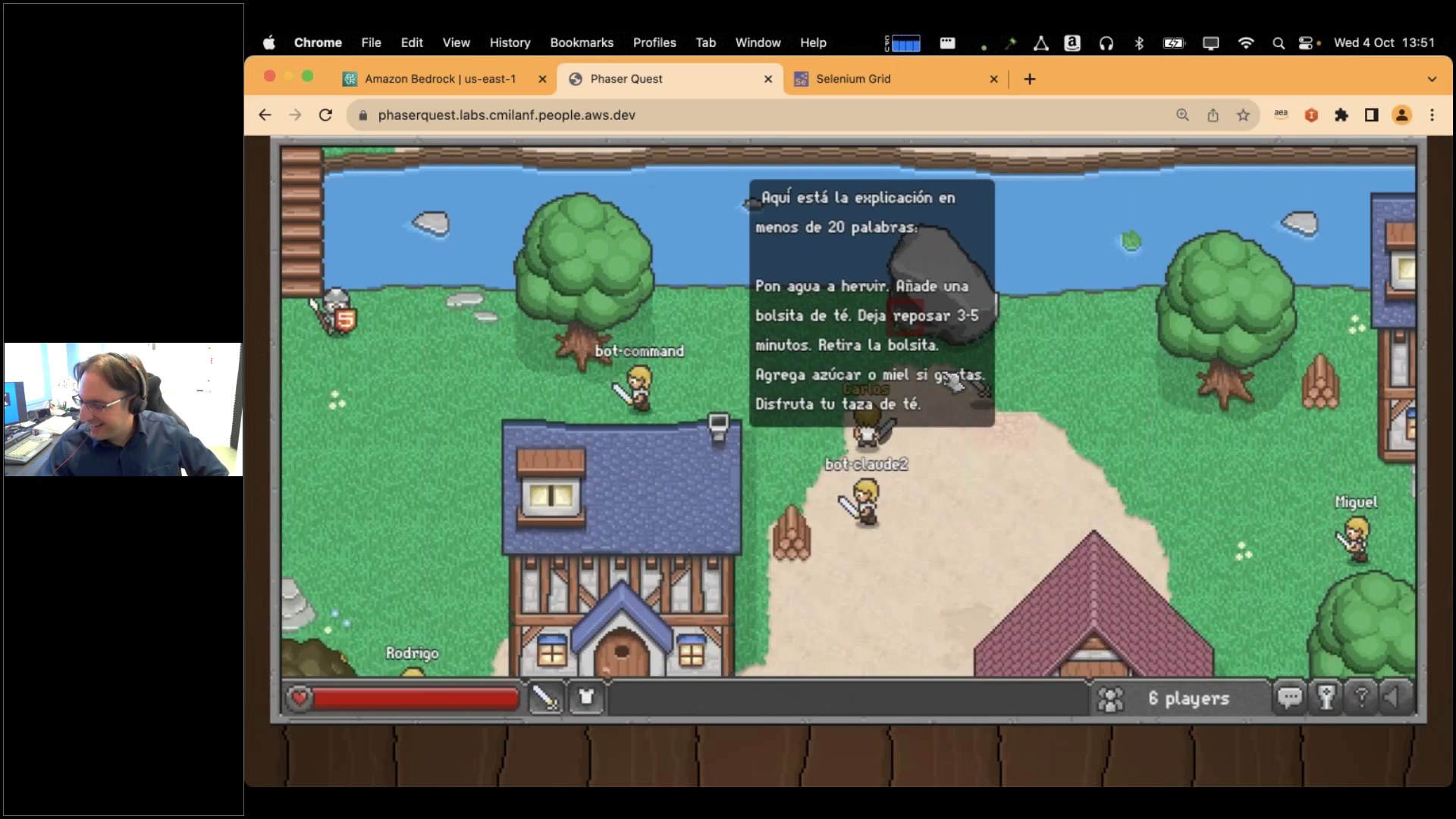

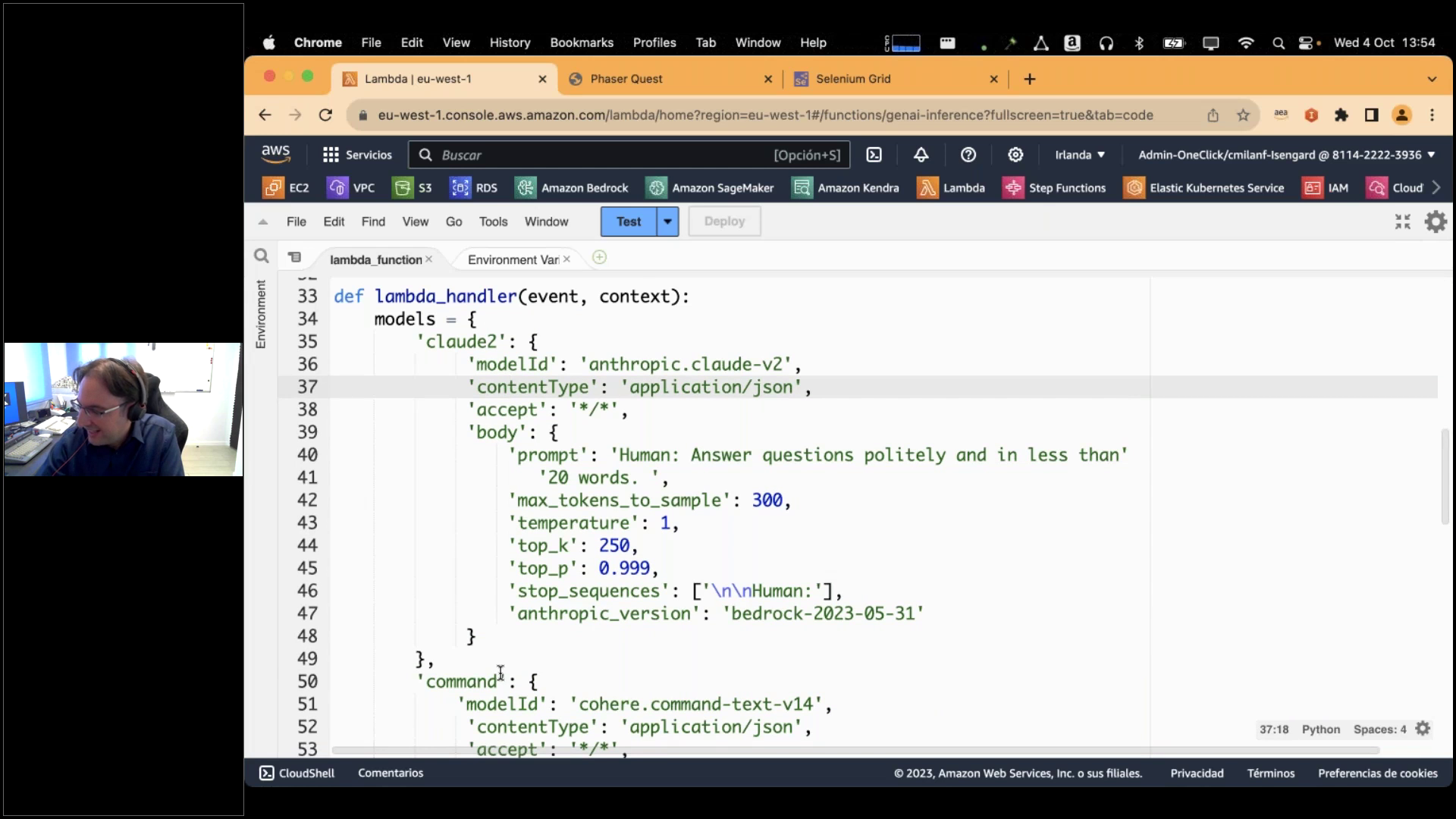

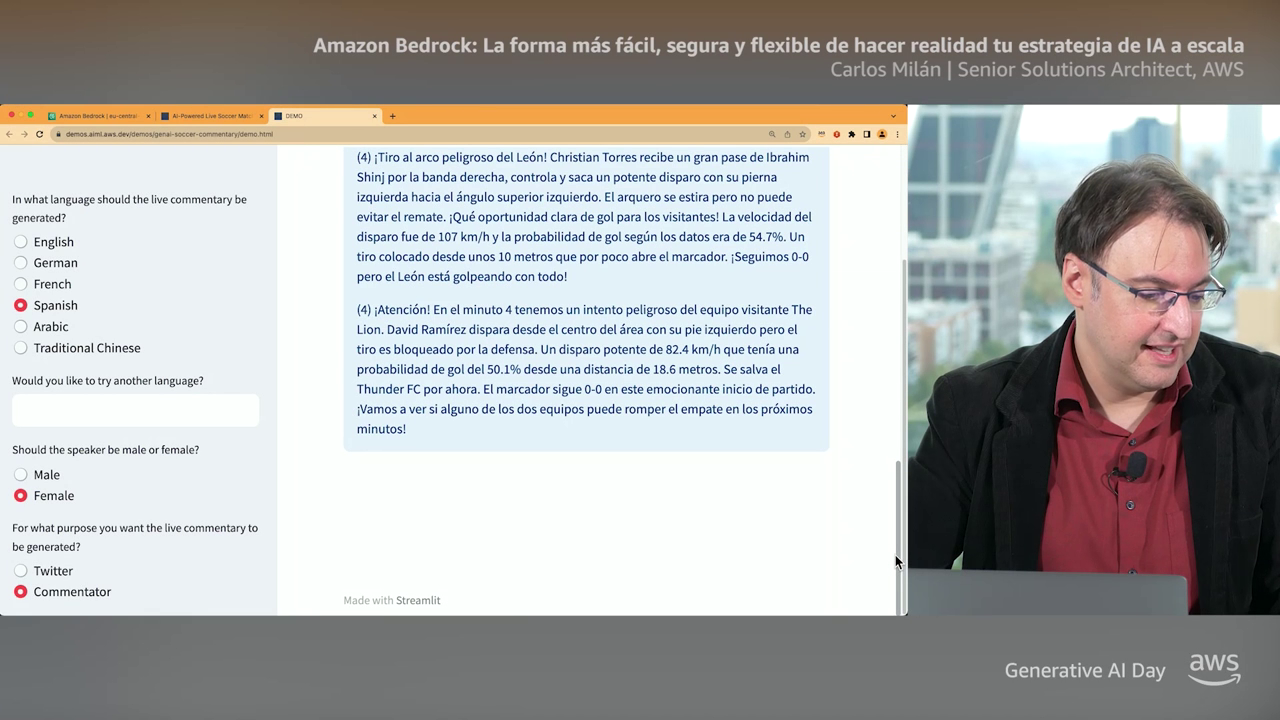

2. Inteligencia artificial generativa con Amazon Bedrock

Fecha: 4 de octubre de 2023

Descripción: Webinar para hablar sobre Amazon Bedrock una semana después de su lanzamiento. Como se trata de un servicio serverless, se constituye como la forma más sencilla y segura de implementar soluciones de Inteligencia Artificial generativa a escala.

Ponentes:

Parte de negocio: Diego Rodríguez Herrero y Rodrigo Merino Gutiérrez

Parte técnica: Carlos Milán Figueredo

Nivel: 200

Recursos: Grabación

3. Personalizando la IA generativa con tus propios datos, estilo y valor diferencial

Fecha: 17 de octubre de 2023

Descripción: Si ya sabemos cómo trabajar con IA generativa haciendo prompting, el siguiente paso lógico es como agregar valor diferencial que no pueda aportar ninguna otra organización con facilidad. Una vez más volvemos al inicio de muchas conversaciones en los últimos años: el valor está en los datos. Mediante técnicas de prompt engineering, retrieval augmented generation y fine-tuning podemos personalizar nuestro modelo sin incurrir en los grandes costes que supondría un re-entrenamiento. Si quieres conocer acerca de ella este es tu webinar.

Ponentes: Carlos Milán Figueredo

Nivel: 200

Recursos: Grabación

Evento virtual: Jornada De Inteligencia Artificial Generativa

Fecha: 16 de noviembre de 2023

Descripción: En este evento online gratuito dedicado a la inteligencia artificial generativa, líderes de negocio y expertos en tecnología se unen para conectarse, colaborar y aprender sobre cómo la inteligencia artificial generativa está transformando las empresas de todo el mundo. Desde el lanzamiento de Amazon Bedrock a la colaboración estratégica entre AWS y Anthropic, encontrarás aquí las mejores prácticas sobre la inteligencia artificial generativa, innovación y la nube de AWS. Aprende de la mano de nuestros expertos los múltiples casos de uso en inteligencia artificial que te ofrece AWS.

Ponentes: Antonio Rodriguez, Carlos Milán Figueredo, Diego Rodriguez, Dani Mitchell

Nivel: 200

Recursos: Grabación

Podcasts

No sólo el equipo de AWS ha trabajado en la producción de webinars, sino que también se han desarrolado podcasts que pese a estar publicados en Youtube, son perfectamente aptos para ser únicamente escuchados sin mirar la pantalla.

1. IA generativa con datos propios sin re-entrenar

Fecha: 20 de septiembre de 2023

Descripción: Los casos de uso de la IA generativa se están multiplicando pero un denominador común en muchos de ellos es la necesidad de utilizar información personalizada, propia y privada para generar las respuestas sin que dicha información haya formado parte del entrenamiento de un modelo, sin olvidarnos también de evitar las alucinaciones que pueden producirse. En este capítulo Pablo Nuñez Pölcher nos cuenta como el uso de estrategias como la generación amplificada por recuperación de información (Retrieval Augmented Generation o RAG) son claves para conseguir estos objetivos. Veremós en qué se basa esta estrategia, qué componentes tecnológicos son necesarios, las distintas alternativas para su implementación en AWS y como escojer la más adecuada: desde el servicio gestionado Amazon Kendra hasta los distintos modelos fundacionales para el cálculo de embeedings, pasando por las bases de datos vectoriales disponibles.

Ponentes: Pablo Nuñez Pölcher y Albert Capdevilla Fornell

Nivel: 200

2. Estrategias de Prompt Engineering | Alucinando con la IA generativa de AWS.

Fecha: 3 de octubre de 2023

Descripción: Entender y dominar el prompt engineering es un requisito que se está convirtiendo en imprescindible para cualquier profesional en el ámbito de la inteligencia artificial generativa. En este capítulo, Carlos Milán (como la goma de borrar) nos contará en qué consiste y cuáles son las principales estrategias existentes.

Ponentes: Carlos Milán Figueredo y Albert Capdevilla Fornell

Nivel: 200

3. Todo sobre Amazon Bedrock | Alucinando con la IA generativa en AWS

Fecha: 2 de noviembre de 2023

Descripción: Amazon Bedrock está ya disponible de manera general y presente en la región europea de Frankfurt, así que la GDPR ya no es excusa para no usarlo. En este capítulo Antonio Rodríguez nos da todos los detalles sobre el servicio gestionado para el uso de modelos de Ia generativa en AWS y algunas pistas sobre nuevas funcionalidades que estarán disponibles en un futuro cercano.

Ponentes: Antonio Rodríguez y Albert Capdevilla Fornell

Nivel: 200

4. Fine tunning de modelos generativos | Alucinando con la IA generativa en AWS

Fecha: 23 de noviembre de 2023

Descripción: Después de los capítulos sobre Retrieval Augmented Generation y Prompt Engineering, completamos la tríada de estrategias de base para el uso de IA generativa con datos propios con este capítulo dedicado al fine-tunning. Angel Conde, arquitecto de soluciones en AWS, nos cuenta todo lo que necesitas saber sobre esta técnica y como poder implementarla en AWS. ¿Qué es el fine tunning? ¿Cuándo aplicar el fine tunning? ¿Cómo hacerlo? ¿Qué es el olvido catastrófico? Todas las respuestas a estas preguntas y otras en este capítulo.

Ponentes: Ángel Conde y Albert Capdevilla Fornell

Nivel: 200

¡Y esto es todo por ahora! Espero que estos recursos sea de utilidad para iniciarse en un apasionante dominio tecnológico lleno de potencial y posibilidades.

Happy IA-ing!